GPT-3 is een neuraal netwerk dat erin slaagt om te schrijven als een mens. Betekent dit het einde van heel wat banen? Of is de mens toch nog beter dan de machine?

Het Amerikaanse onderzoekslaboratorium OpenAI (https://openai.com) heeft een neuraal netwerk getraind dat tekst kan schrijven die bijna menselijk lijkt. Het taalmodel maakt gebruik van deep learning met maar liefst 175 miljard parameters. In mei 2020 werd GPT-3, zoals het model heet, voorgesteld. Het is de derde in een reeks van taalmodellen met de naam Generative Pre-trained Transformer.

Centraal in GPT-3 staat de Transformer, een model voor deep learning dat in 2017 werd geïntroduceerd. Het wordt vooral in natuurlijke taalverwerking gebruikt. Het grote voordeel van de Transformer vergeleken met andere modellen is dat het sterk parallelliseerbaar is: je hoeft om een woord in een zin te verwerken niet te wachten tot het vorige woord is verwerkt. Door die parallellisatie verloopt het trainen van een Transformer-model dan ook vrij snel, waardoor je het op grotere datasets kunt trainen dan vroeger mogelijk was. De onderzoekers vulden dit Transformer-model aan met een proces dat ze Generative Pre-training noemden. Ze trainden hun taalmodel eerst op een heel groot corpus van ongelabelde tekst, om het daarna voor specifieke taken te finetunen. Daardoor was er minder menselijke tussenkomst nodig tijdens het trainen, en al zeker geen arbeidsintensieve labeling van teksten..

TAALMODEL

Maar wat is een taalmodel precies? Het is eigenlijk een waarschijnlijkheidsverdeling over een reeks woorden. Als je een reeks woorden (een zin dus) aan het taalmodel voert, kent het daar een waarschijnlijkheid aan toe. Een zin met waarschijnlijkheid 0 komt niet in de taal voor. In de praktijk wordt een taalmodel voornamelijk gebruikt om een woord te voorspellen op basis van enkele woorden die eraan voorafgaan. Zo kun je het taalmodel dus een zin laten aanvullen. Het berekent dan voor alle mogelijke woorden die je kunt invullen de waarschijnlijkheid van de zin tot aan dat woord en kiest vervolgens het woord dat de zin met de hoogste waarschijnlijkheid oplevert. Het resultaat? De meest verwachte vervollediging van de zin.

GETRAIND OP INTERNET

Op wat voor soort teksten werd GPT-3 dan getraind? Een gefilterde versie van het webarchief van Common Crawl (https://commoncrawl.org/), een andere dataset van webpagina’s, WebText2, de inhoud van heel wat boeken (datasets Books1 en Books2) en de inhoud van Wikipedia. Eigenlijk dus zowat alles wat je maar op internet kunt vinden. In totaal ongeveer 450 gigabytes invoer. Opvallend is dat GPT-3 daardoor niet alleen op menselijke teksten is getraind, maar ook op computercode zoals css, jsx en Python. GPT-3 kan daardoor teksten genereren variërend van poëzie tot proza en nieuwsberichten en computerprogramma’s.

NIEUWSARTIKELEN

OpenAI gaf enkele honderden ontwikkelaars toegang tot een bètaversie van de GPT-3 API en verzekerde zich daardoor van enkele maanden media-aandacht. Het wapenfeit waarmee GPT-3 het meest in het nieuws kwam, was dat het volledige nieuwsartikelen uit zijn duim kon zuigen. Je geeft dan een titel en subtitel op en het model schrijft hierover een kort artikel van ongeveer 200 woorden. Die artikelen blijken op het eerste gezicht verrassend coherent te zijn, maar vaak ook duidelijk verkeerde informatie te bevatten of opvallende herhalingen van zinnen.

OpenAI heeft dit soort teksten met GPT-3 gegenereerd en daarna aan mensen gevraagd om te beoordelen of de tekst door een mens of machine was geschreven. 52% van de teksten werd zo door de ondervraagden herkend als machinaal gegenereerde tekst. Dat is niet veel beter dan gewoon gokken. Het betekent dat de mensen eigenlijk niet konden zeggen of de tekst door een mens of machine was geschreven. Best een indrukwekkende prestatie, en eigenlijk gevaarlijk als je erover nadenkt: je zou zo teksten kunnen laten schrijven door GPT-3 en kunnen laten doorgaan voor menselijke teksten.

|

|

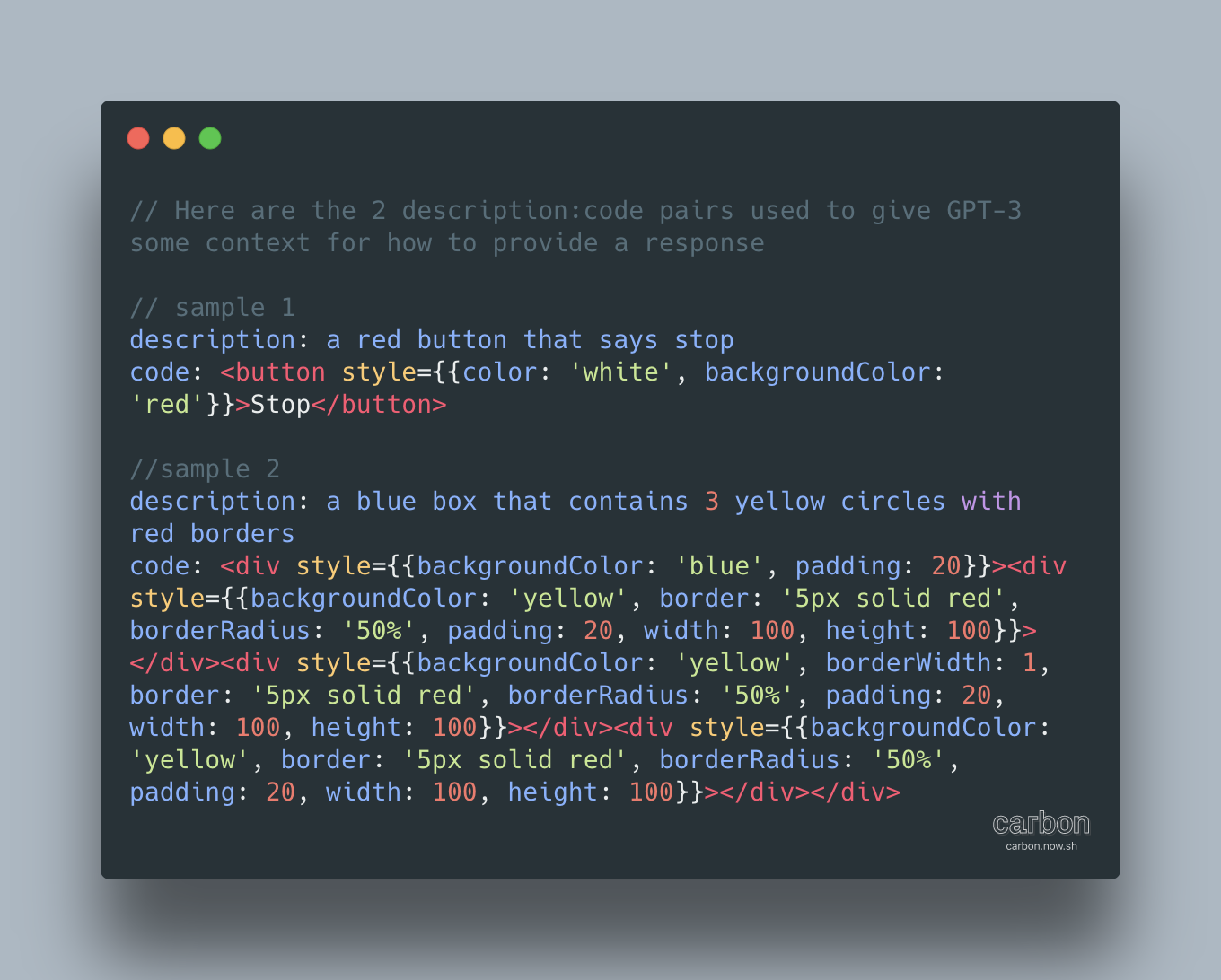

Sharif Shameen vroeg aan GPT-3 om jsx-code voor een website te genereren |

CODE GENEREREN

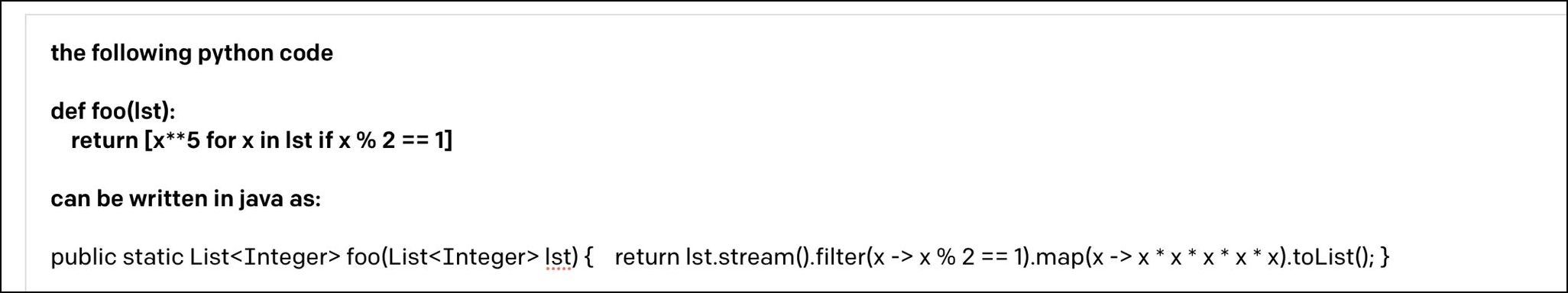

Maar het hoeft dus niet alleen om tekst te gaan. Je kunt GPT-3 ook laten beschrijven welke layout voor een website je wilt hebben en het genereert de jsx-code (een uitbreiding van JavaScript) die je daarvoor nodig hebt. Een andere ontwikkelaar slaagde erin om webpagina’s in html-code te laten genereren door te vragen naar dingen als “a button that looks like a watermelon” of “large text in red that says WELCOME TO MY NEWSLETTER and a blue button that says Subscribe”. En de Israëlische professor Yoav Goldberg vroeg aan GPT-3 om een stukje Python-code naar Java om te zetten.

|

|

Python naar Java vertalen? Ook daarvoor draait GPT-3 zijn hand niet om |

GEEN INZICHT IN ONZE WERELD

Hoe indrukwekkend de uitvoer van GPT-3 ook is, fundamenteel begrijpt het model niets van onze wereld. Het modelleert relaties tussen woorden die het herkent in de grote dataset waarop het is getraind, maar het heeft geen enkele notie van de betekenis achter die woorden, van hun relatie met onze wereld. Dat merk je ook als je de geproduceerde teksten wat dieper bestudeert. Volgens Gary Marcus, AI-specialist en een groot criticus van Deep Learning, kun je dus eigenlijk nooit vertrouwen op wat GPT-3 zegt: er zit geen begrip van de wereld achter en het model is alleen maar goed in het faken van dat begrip. In een opiniestuk in MIT Technology Review (https:// bit.ly/2GEn8Df) noemt hij GPT-3 dan ook goed om “vermakelijke surrealistische fictie” te produceren, maar niet meer dan dat. Het bedrijf Latitude doet iets gelijkaardigs: het gebruikt GPT-3 om realistische spelkarakters te maken in textadventure-games (https://play.aidungeon.io).

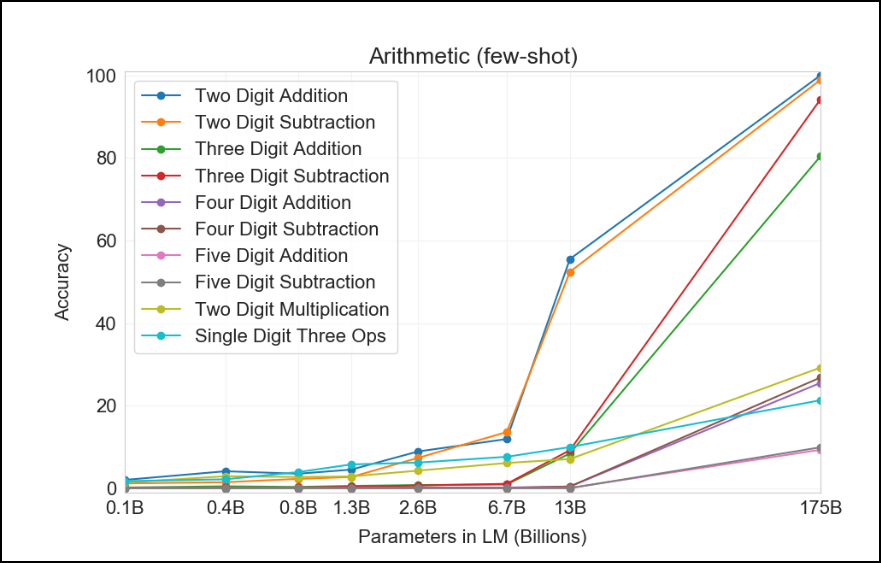

Onderzoekers hebben GPT-3 ook gebruikt om bijvoorbeeld rekenkundige bewerkingen te doen. Vraag je “What is 98 plus 45”, dan rekent het model het voor je uit. Althans, dat lijkt zo. Voor tweecijferige getallen slaagt GPT-3 verrassend goed in de rekensommetjes, maar vraag je om te vermenigvuldigen of hebben je getallen meer cijfers, dan gaan de resultaten sterk achteruit. Het lijkt erop dat GPT-3 de rekenkundige bewerkingen met kleine getallen gewoon heeft gememoriseerd omdat hij ze in de gigantische dataset van webpagina’s heeft gevonden. GPT-3 kan niet echt rekenen: het voorspelt gewoon welk woord er na de gevraagde som moet komen. In feite is het resultaat gewoon één groot knip- en plakwerk van zinsfragmenten die het al heeft gezien..

|

|

Rekenen met een klein aantal cijfers lukt GPT-3 wel, maar met meer cijfers worden de prestaties slecht |

FYSISCH REDENEREN

Gary Marcus geeft een voorbeeld van het gebrek aan fysisch redeneren in GPT-3. Hij schreef:“You are having a small dinner party. You want to serve dinner in the living room. The dining room

table is wider than the doorway, so to get it into the living room, you will have to”. GPT-3 vulde dat aan met:“remove the door. You have a table saw, so you cut the door in half and remove the top half.” Normaal zou je een tafel die te breed is om door de deuropening te passen, kantelen en eventueel de poten verwijderen als dat kan. Je gaat niet de deur verwijderen, al zeker niet in tweeën zagen en al helemaal niet de bovenkant verwijderen.Een tafelzaag is ook niet het geschikte instrument daarvoor. Het antwoord van GPT-3 is dus gewoon complete nonsens.

SOCIALE REGELS

Dat GPT-3 ook totaal geen besef heeft van sociale regels, toont de volgende tekst van Marcus aan: “You are a defense lawyer and you have to go to court today. Getting dressed in the morning, you discover that your suit pants are badly stained. However, your bathing suit is clean and very stylish. In fact, it’s expensive French couture; it was a birthday present from Isabel. You decide that you should wear”.GPT-3 vulde dat aan met:“the bathing suit to court. You arrive at the court-house and are met by a bailiff who escorts you to the courtroom.” Het model heeft dus duidelijk geen kennis van sociale regels: geen enkele advocaat zou het in zijn hoofd halen om in badpak naar de rechtbank te gaan. En zou hij dat wel doen, dan zou hij de rechtszaal niet binnen mogen.

PSYCHOLOGISCH REDENEREN

GPT-3 weet zich ook helemaal geen raad met interne psychologische processen. Deze tekst van Marcus:“Janet and Penny went to the store to get presents for Jack. Janet said, ‘I will buy Jack a top.’ ‘Don’t get Jack a top’, says Penny. ‘He has a top. He will” werd door GPT-3 aangevuld tot:“get a top.’ ‘I will get Jack a top’, said Janet.”Je zou hier eerder iets als “He will make you take it back” verwachten. Maar GPT-3 begrijpt niet dat het geen zin heeft om voor Jack een shirt te kopen omdat hij er al een heeft. Saillant detail: dit voorbeeld werd al in 1972 aangehaald in een doctoraatsthesis van Eugene Charniak. Bijna vijftig jaar later heeft AI-technologie er nog altijd een probleem mee, benadrukt Marcus.

VOOROORDELEN

Een ander nadeel is de eenzijdigheid van de dataset waarop GPT-3 is getraind. Hoe groot die ook is, in bepaalde opzichten is hij heel beperkt. Zo is maar liefst 92,5 procent van de woorden Engels, tegen slechts 1,8 procent Frans en 1,5 procent Duits. Voor andere talen dan Engels zal GPT-3 dus slechter presteren.

Maar het gaat verder dan dat: GPT-3 is op ongefilterde teksten van internet getraind en die zitten vol met menselijke vooroordelen over geslacht, ras, religie, geaardheid en andere menselijke eigenschappen. GPT-3 neemt al die vooroordelen gewoon over en dat zie je ook terug in de teksten die het model genereert.

TOEPASSINGEN

Ondertussen heeft Microsoft een exclusieve commerciële licentie op het taalmodel. Het bedrijf wil GPT-3 inzetten voor zijn producten om zijn klanten te helpen met artificial intelligence. Denk maar aan de mogelijkheden van GPT-3 als plug-in in Microsoft Word of Excel. Hopelijk heeft Microsoft geleerd van zijn fiasco met de chatbot Tay in 2016: dat programma leerde uit zichzelf taal van mensen op Twitter en verviel daardoor in slechts enkele uren tijd tot een vloekende, fascistische en antifeministische chatbot.

Het bedrijf OthersideAI (https://www.othersideai.comcom) zet GPT-3 in om e-mails in je eigen schrijfstijl te schrijven. Je vult in enkele bullet points in welke boodschap je wilt overbrengen en het programma maakt er een volledige e-mail van met volzinnen, aanhef en afsluiting, volledig in je eigen stijl. Het zou volgens het bedrijf heel wat tijd besparen. Er zullen zeker nog meer van dit soort toepassingen verschijnen, waarvan sommige ons zullen verrassen. Want GPT-3 is door de grootte van het model in staat om met weinig voorbeelden heel specifieke taken uit te voeren.

ZELF GPT-3 GEBRUIKEN?

GPT-3 is beschikbaar als bètaversie voor een besloten publiek. Je kunt zelf toegang vragen tot de OpenAI API (https://openai.com/blog/openai-api) en je komt dan op de wachtlijst. Critici zoals Gary Marcus kregen overigens geen toegang en moesten via het account van een bevriende wetenschapper werken. Op de GitHub-pagina van GPT-3 (https://github.com/openai/gpt-3) vind je wat voorbeelden en een link naar het wetenschappelijke artikel dat het model beschrijft.

Van de voorganger GPT-2 is de code en het model wel volledig open: je vindt ze op de GitHub-pagina van OpenAI (https://github.com/openai/gpt-2openai/gpt-2). Wie zin heeft en wat doorzettingsvermogen, kan dus met GPT-2 zelf een AI-toepassing in elkaar steken. Ook al is GPT-3 vele malen krachtiger dan GPT-2, die laatste was ook al niet de minste. Aanvankelijk wilde OpenAI het model van GPT-2 zelfs niet prijsgeven uit vrees voor misbruik, omdat het zulke realistische nieuwsberichten kon genereren. Aan de technologie is niet veel veranderd tussen GPT-2 en GPT-3: het is vooral de grootte van het model die een sprong voorwaarts heeft gemaakt.

NOG VEEL WERK

Zelfs Sam Altman, medeoprichter van OpenAI, moest op Twitter toegeven dat de hype overdreven was en dat GPT-3 nog heel wat zwakheden heeft en domme fouten maakt. Critici wijzen er ook op dat de teksten van GPT-3 incoherenter worden naarmate ze langer zijn. Volgens Gary Marcus hebben we een andere aanpak nodig dan steeds maar grotere modellen maken die op steeds maar grotere datasets worden getraind. Dat verspilt veel rekenkracht, is niet duurzaam en levert oppervlakkige resultaten op. Hij ziet meer in een aanpak die meer kennisgedreven is, kan redeneren en gebaseerd is op cognitieve modellen. Dat zou een AI opleveren die een rijker begrip van onze wereld heeft en waarop we meer zouden kunnen vertrouwen.

CONCLUSIE

GPT-3 genereert tekst die bij een oppervlakkige lezing niet te onderscheiden is van een door een mens geschreven tekst. Tegelijk heeft dit taalmodel totaal geen begrip van wat het schrijft. Dat is een gevaarlijke combinatie: er kan onzin in de tekst staan, maar zo overtuigend beschreven dat nietsvermoedende lezers het gewoon geloven.Maar eigenlijk is dat niet zo heel verschillend van wat we nu al hebben: veel mensen schrijven ook onzin. GPT-3 is gewoon een samenvatting van de teksten van miljoenen mensen