Iedereen heeft in zijn kindertijd wel verstoppertje gespeeld. Na een tijd had je misschien inventieve strategieën ontwikkeld om je te verstoppen. OpenAI liet virtuele bots ook het spelletje spelen, met verrassende uitkomsten.

OpenAI (https://openai.com/) is een organisatie die onderzoek doet naar kunstmatige intelligentie die de mensheid voordeel moet opleveren. Ze is in 2015 onder andere door Elon Musk en Sam Altman opgericht uit bezorgdheid over de risico’s van kunstmatige intelligentie. Samen met enkele andere investeerders staken ze meer dan een miljard in de organisatie. Afgelopen zomer kondigde Microsoft aan dat het een miljard dollar in OpenAI investeert.

Het laatste wapenfeit van OpenAI is dat de organisatie virtuele bots verstoppertje liet spelen (https://openai.com/blog/emergent-tool-use/) totdat ze er extreem goed in waren. De onderzoekers leerden de bots niets expliciet, maar lieten hen op eigen houtje uitzoeken hoe ze moesten voorkomen dat ze gevonden werden. Daarbij ontwikkelden de bots diverse verrassende strategieën waarbij ze zelfs met elkaar samenwerkten. En de tegenstanders ontwikkelden contrastrategieën.

|

|

Verstoppertje spelen vereist complexe vaardigheden |

Virtueel verstoppertje

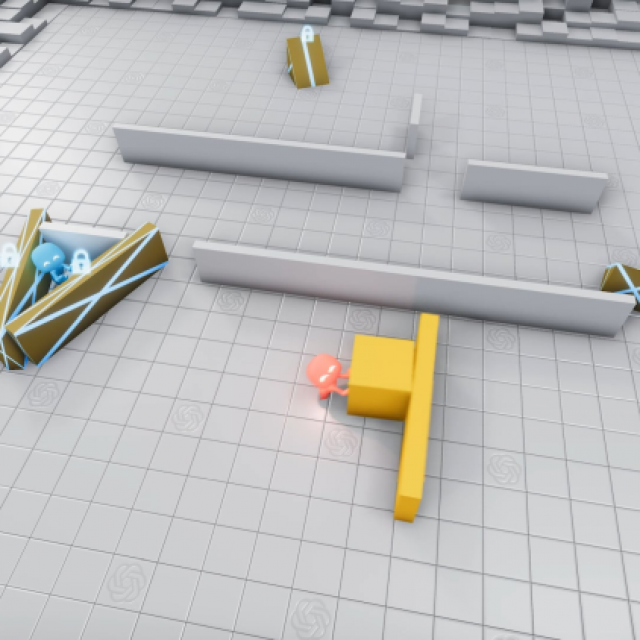

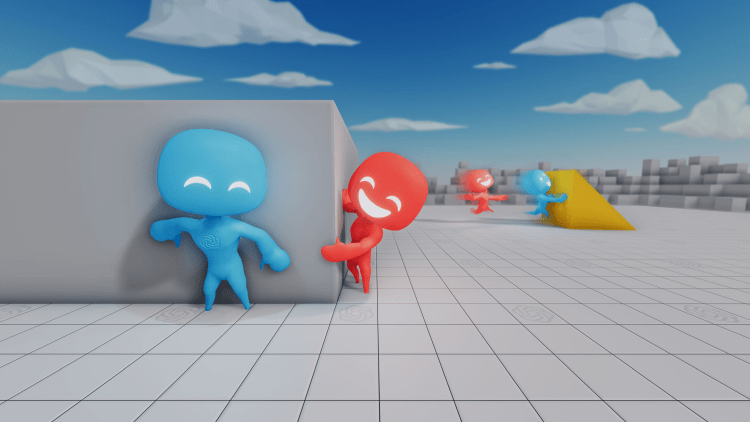

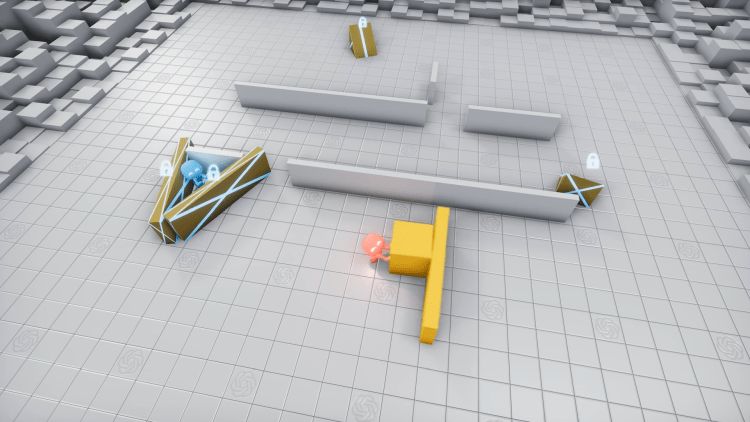

In de virtuele omgeving van OpenAI zijn er twee teams: de verstoppers (blauw) en de zoekers (rood). De verstoppers hebben als taak gekregen te voorkomen dat ze in het zicht van de zoekers komen. De zoekers hebben als taak dat ze de verstoppers zoveel mogelijk in het vizier moeten houden. Voor het spel begint, krijgen de verstoppers even de tijd om zich voor te bereiden; de zoekers kunnen zich ondertussen niet bewegen.

De virtuele omgeving bevat allerlei objecten zoals dozen en hellingen die de bots kunnen verplaatsen en vastzetten (een object dat is vastgezet, kan alleen door hetzelfde team weer worden losgemaakt), en er zijn diverse ruimtes met openingen. De bots hebben geen regels in hun brein ingeplant gekregen over wat ze met die objecten en ruimtes moeten doen.

Ze worden continu geëvalueerd op hun gedrag als team. De score van de verstoppers verhoogt met 1 als alle teamleden verborgen zijn en verlaagt met 1 als er ook maar één verstopper door een zoeker gezien wordt. De score van de zoekers wordt dan weer verlaagd met 1 als geen van de verstoppers zichtbaar is en wordt verhoogd met 1 als er minstens één verstopper in het vizier is.

|

|

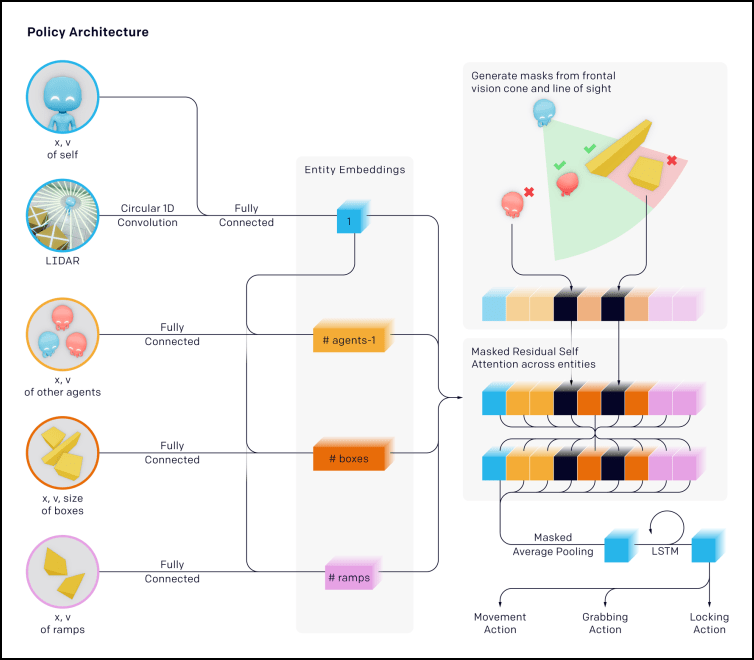

Elke bot leert uit de informatie die het heeft over zichzelf, de andere bots en zijn omgeving. |

Emergent gedrag

Met deze regels worden de bots dan heel wat keren getraind: ze spelen een groot aantal spelletjes verstoppertje met en tegen elkaar en leren uit de resultaten. Blijkt een strategie een hogere score voor het team op te leveren, dan gaan ze verder met deze strategie en proberen ze er varianten van uit om nog betere resultaten te halen. Blijkt een strategie niet zo succesvol te zijn, dan zoeken ze een andere.

Na vele trainingsspelletjes bleek dat de bots maar liefst zes verschillende strategieën ontwikkelden. In die strategieën interageerden ze op complexe manieren met hun omgeving en elkaar, zónder dat dit hen expliciet aangeleerd was en zelfs zonder dat ze een beloning kregen voor die interacties. We spreken dan van emergent gedrag.

Eenvoudige omgeving

De onderzoekers begonnen met een eenvoudige omgeving: twee bots in elk team, twee dozen, een helling en één vaste kamer met één of twee willekeurig geplaatste deuropeningen. De bots begonnen met willekeurige acties uit te voeren. Na 2,69 miljoen spelletjes leerden de zoekers dat ze actief achter de verstoppers aan moesten jagen. Voordien liepen ze maar wat willekeurig rond en ontdekten ze zomaar toevallig de verstoppers.

Na 8,62 miljoen spelletjes leerden de verstoppers dat ze de zoekers konden tegenhouden door de dozen naar de deuropeningen te verplaatsen en ze daar vast te zetten, zodat de zoekers er niet meer door konden en hen ook niet meer zagen. De zoekers gaven zich echter niet gewonnen: na 14,5 miljoen spelletjes ontdekten ze dat ze over de muren van de kamer konden springen door de helling tegen de muur te schuiven en er dan overheen te lopen. Helaas voor hen ontdekten de verstoppers na 43,4 miljoen spelletjes dat ze dit konden voorkomen door de helling eerst in hun kamer mee te nemen voordat ze die met de dozen afsloten.

De verstoppers leerden overigens ook samenwerken als team: als beide dozen zich te ver van de deuropeningen bevonden om zowel de helling als de dozen in één keer op tijd op de juiste plaats te krijgen, duwde een van de bots een doos door naar de andere, zodat ze toch op tijd hun kamer konden afsluiten. Dat is verrassend emergent gedrag. De verstoppers wonnen het uiteindelijk overtuigend in deze eenvoudige omgeving.

|

|

De verstoppers leren de deuropeningen af te sluiten met de dozen |

Complexe omgeving

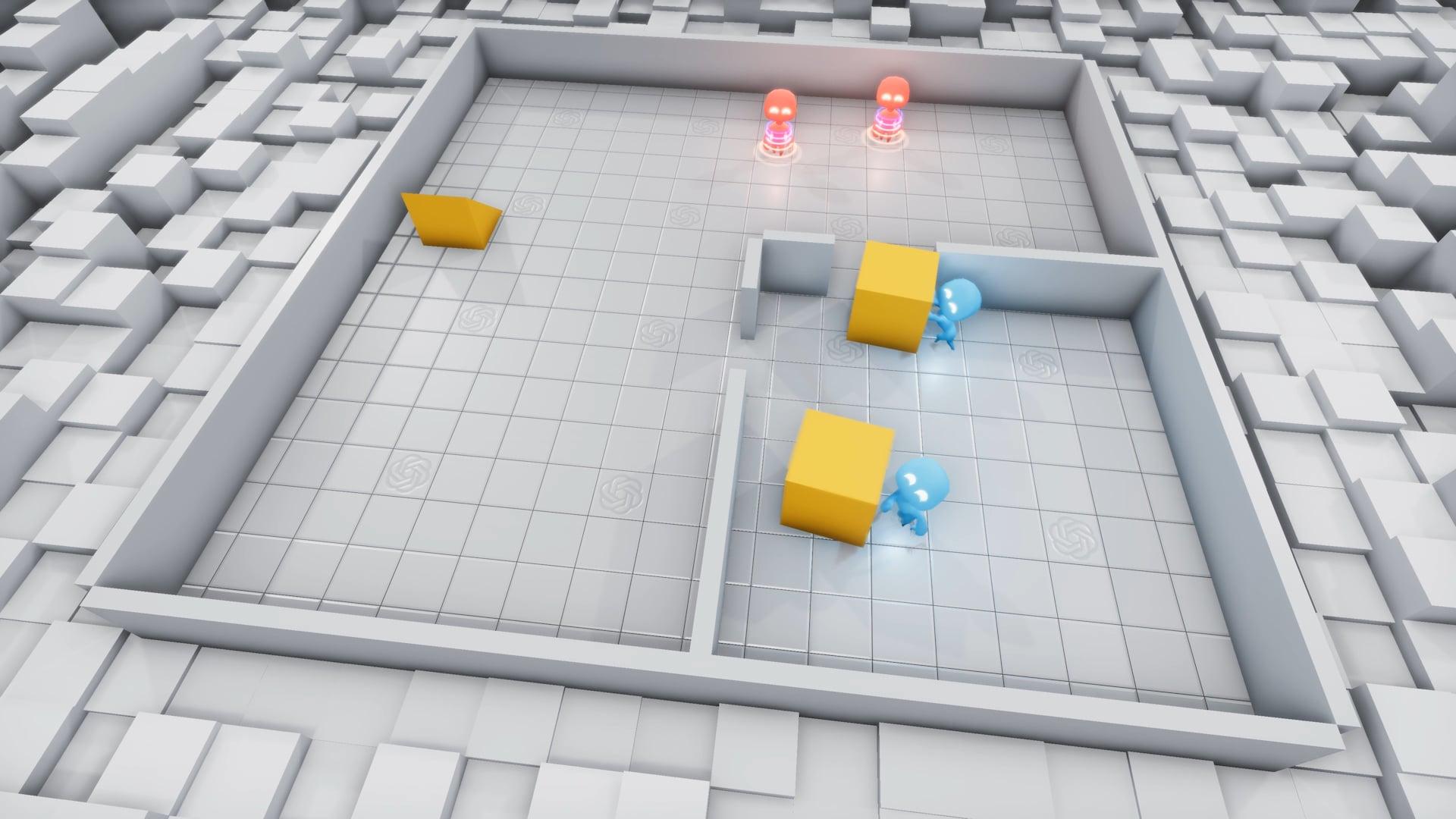

Daarna maakten de onderzoekers de virtuele omgeving complexer en zorgen ze voor meer variatie: 1 tot 3 verstoppers, 1 tot 3 zoekers, 3 tot 9 blokken (dozen en verplaatsbare muren), 2 hellingen en willekeurige kamers en deuropeningen. Het leerproces begon hetzelfde: eerst bewegen alle bots willekeurig en beginnen ze wat doelloos met de objecten rond te schuiven, daarna leren de zoekers dat ze achter de verstoppers aan moeten lopen en de verstoppers leren zich te verbergen.

Omdat de omgeving deze keer veel vrijer is, doen ze dat niet alleen door deuropeningen met dozen af te sluiten, maar ook door met dozen en verplaatsbare muren een schuilplaats te maken. En alweer leren de zoekers om met de helling over obstakels te springen en de schuilplaats in te geraken. En weer leren de verstoppers dat ze dit kunnen voorkomen door de hellingen vast te zetten.

De onderzoekers dachten dat de bots nu alles wel geleerd hadden, maar na 458 miljoen spelletjes leerden de zoekers een spectaculair nieuw kunstje: ze schoven een doos naast een helling en sprongen zo op de doos. En ze maakten ook op een creatieve manier gebruik van de fysicaregels van de virtuele wereld, die bepalen dat de bots zich kunnen bewegen door kracht op zichzelf uit te oefenen, of ze zich nu op de grond bevinden of niet. Op deze manier konden de zoekers op een doos ‘surfen’ tot de schuilplaats van de verstoppers en die zo te betreden.

De verstoppers reageerden hier dan weer op door voordat ze zich verbergen alle losstaande objecten vast te zetten. Dat is dan na 481 miljoen spelletjes de strategie waarmee de verstoppers in de meeste situaties het spel winnen.

|

| De verstoppers maken hun eigen schuilplaats en zetten de hellingen vast, zodat de zoekers die niet kunnen gebruiken. (Bron: OpenAI) |

Onverwacht gedrag

De onderzoekers merkten in die honderden miljoenen spelletjes enkele keren heel onverwacht gedrag op dat niet altijd gewenst was. Zo leerden sommige verstoppers in de complexe omgeving om gewoon een doos te nemen en er eindeloos mee weg te rennen. De onderzoekers besloten daarom om strafpunten te geven aan bots die te ver weglopen.

Het surfen op een doos vermeldden we al: dat was een knap staaltje ‘fysica-hacking’. Maar de hellingen bleken nog enkele andere gevolgen te hebben die de onderzoekers helemaal niet hadden voorzien en die eigenlijk fouten in de physics engine uitbuitten…

Zo maakten de verstoppers misbruik van de contactfysica en slaagden ze erin om hellingen uit het speelgebied van de eenvoudige omgeving te verwijderen. Dat deden ze door de helling met kracht tot tegen de muur te schuiven waardoor die over de muur vloog. Dat was niet de bedoeling.

De zoekers leerden een nog spectaculairder kunstje: als een bot met een helling naar de muur loopt en die in de juiste hoek raakt, vliegt niet alleen de helling weg, maar wordt ook de bot zelf de lucht in gekatapulteerd, waardoor hij zichzelf tot in de afgesloten schuilplaats van de verstoppers lanceert. Ook dat was niet de bedoeling.

Wat hebben de bots nu geleerd?

De bots hebben na honderden miljoenen spelletjes dus complexe strategieën en contrastrategieën geleerd, evenals vaardigheden zoals samenwerking met teamleden en creatief gebruik van de omgeving. Daarom wilden de onderzoekers weten of de bots deze vaardigheden ook in een andere context konden gebruiken. Wat dat is nu eenmaal een eigenschap van echte intelligentie.

Hoe spectaculair het gedrag in het spelletje verstoppertje ook was, zodra de onderzoekers de bots in een andere context plaatsten, was het gedrag teleurstellend. Zo was duidelijk dat de bots in de context van verstoppertje spelen heel precies objecten konden verplaatsen om een schuilplaats te construeren. Maar als ze gevraagd werden om een schuilplaats te construeren in een andere context, zonder dat ze zich moesten verbergen voor zoekers, presteerden de bots daar niet beter in dan bots die deze vaardigheid niet aangeleerd hadden.

Evolutie van de mens

De onderliggende veronderstelling van de onderzoekers is dat ze met die honderden miljoenen spelletjes in een virtuele omgeving een proces zoals de evolutie van het leven op aarde nabootsen. De virtuele bots hebben duidelijk op basis van enkele eenvoudige regels complexe strategieën van samenwerking en gebruik van tools aangeleerd, net zoals wij mensen in de evolutie dit soort vaardigheden hebben gekregen. OpenAI verwacht dan ook dat ze met deze aanpak nog veel complexere vormen van kunstmatige intelligentie kunnen ontwikkelen.