Steeds meer beslissingen worden voor ons genomen door algoritmes: ze bepalen bijvoorbeeld of je een lening krijgt of hoeveel je moet betalen voor je vliegreis. Vaak wordt gezegd dat machines eerlijker zijn, omdat ze objectief naar je dossier kijken. Maar is dat zo?

In 2014 voerde Amazon een experiment uit waarbij het kandidaten voor een baan screende met kunstmatige intelligentie. De bedoeling was dat de hr-afdeling van het bedrijf de talloze binnenkomende cv’s deels automatisch zou kunnen evalueren. De hr-managers droomden al van een machine waar ze honderd cv’s in konden gooien en die dan de vijf beste kandidaten daaruit zou selecteren.

Het programma gaf kandidaten op basis van een automatische analyse van hun cv één tot vijf sterren, net zoals de beoordelingen van producten in Amazons webwinkel. Het computermodel werd getraind op cv’s die het bedrijf over een periode van tien jaar had ontvangen.

Niet genderneutraal

Maar tegen 2015 bleek al dat Amazons AI-programma verre van genderneutraal was: cv’s met termen als ‘women’s chess club captain’ kregen systematisch een lage score voor vacatures voor softwareontwikkelaars en andere ict-profielen. Dat was eigenlijk wel te verwachten: de cv’s waarop het systeem getraind was voor die profielen, kwamen vooral van mannen, omdat die nu eenmaal oververtegenwoordigd zijn in de technologiesector.

Na die ontdekking werd het programma aangepast, maar de makers konden niet uitsluiten dat er nog andere subtiele vormen van discriminatie in het algoritme verborgen bleven en ze vertrouwden het zaakje niet. Het project werd dan ook uiteindelijk stopgezet.

Het pleit voor Amazon dat men zich er bewust van was dat het algoritme dat ze aan het ontwikkelen waren, niet eerlijk was. De vraag is of elk bedrijf daar zo bewust mee omgaat. En dat AI een steeds grotere impact op ons leven zal hebben, staat vast. In een enquête door CareerBuilder uit 2017 antwoordde 55% van de Amerikaanse hr-managers dat AI in de vijf jaar erna een vast onderdeel van hun werk zou worden.

Vooroordelen in onze data

Op heel wat plaatsen draaien programma’s die beslissingen nemen die door mensen zonder nadenken voor waar worden aangenomen, maar die een specifieke groep mensen discrimineert. Dat is het probleem van ‘algoritmische eerlijkheid’. Dat begint al bij de data waarmee je werkt. Algoritmes voor machinaal leren herkennen statistische patronen in data.

Maar data die we aan de algoritmes aanleveren, zijn nooit neutraal: ze zijn gekleurd door discriminatie (zoals in het experiment van Amazon) en door onze vooroordelen. De algoritmes herkennen die discriminatie of vooroordelen en maken die hen eigen.

Het risico bestaat zelfs dat algoritmes aanwezige vooroordelen nog vergroten. Zo ontdekten onderzoekers enkele jaren geleden dat het veelgebruikte door Google ontwikkelde algoritme word2vec stereotypes in teksten vergroot (https://arxiv.org/pdf/1607.06520.pdf of https://bit.ly/2aFrFkH). Ze trainden word2vec op nieuwsartikelen uit Google News en kwamen tot de vaststelling dat het algoritme homemaker, nurse, receptionist enzovoort als typisch vrouwelijke beroepen beschouwde en captain, architect, boss enzovoort als typisch mannelijke beroepen.

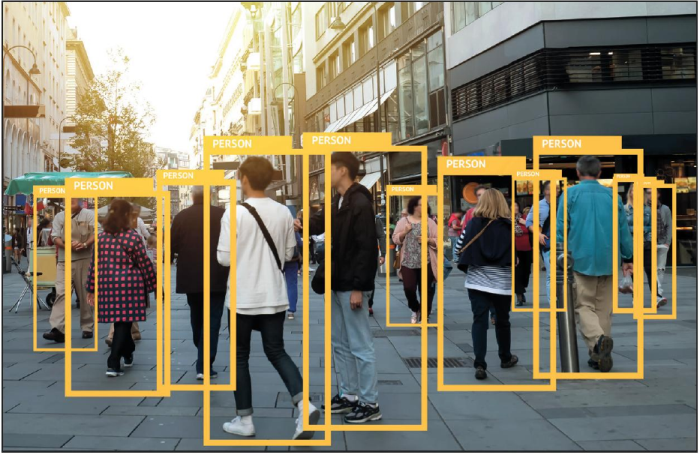

AI plakt op elk van ons een label, maar klopt dat label?

Vooroordelen vermijden

Je kunt argumenteren dat dit niet het probleem van de algoritmes is, maar van de data. In het ideale geval lost het probleem zichzelf op naarmate wij ons als maatschappij bewuster worden van die vooroordelen en ons taalgebruik genderneutraler maken. Je kunt de AI dan regelmatig hertrainen op recentere gegevens, waardoor het algoritme samen met de mens beetje bij beetje zijn vooroordelen verliest.

Maar de aanwezige vooroordelen zijn voor een individueel nieuwsartikel soms wel heel subtiel en worden door de analyse van massale hoeveelheden nieuwsartikelen door het algoritme versterkt. Een mogelijke oplossing is om de vooroordelen uit een AI-algoritme te halen met een extra filterstap. Maar zelfs als je je al beperkt tot geslacht is dat niet zo eenvoudig. Zo getuigt het van een vooroordeel om naar een dokter waarvan je het geslacht niet weet te verwijzen met “hij”, terwijl het wat vreemd zou zijn als je iemand met prostaatkanker niet als “man” omschrijft. Kortom, een AI-algoritme dat genderneutraal wil zijn, moet wel met geslachtsspecifieke betekenissen rekening houden.

De computer als instrument tegen vooroordelen

Ondanks de moeilijkheden van een genderneutrale filter voor word2vec, vinden de onderzoekers die het probleem aankaartten dit een zinvolle actie: omdat word2vec zoveel wordt gebruikt in automatische analyses van teksten, kan een filter hierin de vooroordelen in onze teksten verminderen of tenminste niet versterken, wat op termijn hopelijk helpt om de vooroordelen in onze maatschappij ook te verminderen. Ze zagen overigens gelijkaardige etnische en culturele stereotypes door word2vec versterkt worden, maar daarvoor is het nog complexer om een filter te ontwikkelen die de analyses van teksten neutraler maakt.

Een andere visie is dat de ‘vooroordelen’ in onze samenleving (bijvoorbeeld dat een computerprogrammeur vaker met een man wordt geassocieerd dan met een vrouw) gewoon het gevolg zijn van statistische gegevens in de wereld: er zijn nu eenmaal meer computerprogrammeurs man dan vrouw. In heel wat toepassingen is het toch interessant om deze gegevens te kunnen analyseren en de ongefilterde AI-algoritmes te gebruiken. Maar de ontwikkelaars van de genderneutrale word2vec vinden het risico op versterking van vooroordelen te groot en ijveren ervoor om zoveel mogelijk hun neutrale versie te gebruiken.

AI behandelt minderheden altijd oneerlijk

Maar zelfs als we een oplossing zouden vinden voor de aanwezigheid van vooroordelen in onze data, zal AI minderheden altijd oneerlijk behandelen. Dat zit zo. Met hoe meer data we een algoritme voor machinaal leren trainen, hoe beter het algoritme presteert. Helaas hebben we over minderheden per definitie minder data. De modellen over minderheden die onze algoritmes voor machinaal leren opleveren, werken dan ook per definitie minder goed dan modellen over de gehele populatie.

Zo zal een algoritme dat de kans berekent dat je een krediet kunt terugbetalen doordat het op talloze gegevens van personen en hun kredieten getraind is, misschien gemiddeld vrij goede voorspellingen doen voor de gehele populatie. Maar voor kleine groepen met een afwijkend terugbetaalgedrag zijn de voorspellingen heel wat minder goed, misschien zelfs niet beter dan het opgooien van een muntstuk!

We weten niet hoe die voorspelling zal zijn: misschien geeft het algoritme een specifieke groep wel onterecht groen licht, of misschien weigert het algoritme die groep wel onterecht kredieten, dus in termen van gevolgen kunnen we niet zeggen of die groep er goed of slecht uitkomt. Maar een algoritme dat voor de meerderheid vrij correct is en voor een minderheid in de helft van de gevallen ernaast zit, kun je vergelijken met een sollicitatieprocedure die voor de meerderheid een hele nauwgezette hr-procedure inzet, terwijl een minderheid beoordeeld wordt door een muntstuk op te gooien. Dat kunnen we bezwaarlijk eerlijk noemen.

Spambots?

Dat verschil in nauwkeurigheid van algoritmes voor meerderheids- en minderheidsgroepen kan in allerlei situaties voorkomen. Denk maar aan een algoritme dat op basis van aangemaakte gebruikersnamen op een sociaal netwerk automatisch voorspelt of het een ‘fake’ gebruiker is met als bedoeling om het netwerk te spammen. Je zou een algoritme kunnen trainen op een reeks namen waarvan bekend is of er echte mensen of spambots achter zaten, en het algoritme leidt daaruit af dat veel voorkomende namen zoals Jan of Piet echt zijn, terwijl namen die niet zoveel voorkomen fake zijn.

Maar hoewel die stelregel misschien wel in onze westerse samenleving opgaat, zijn namen in heel wat andere culturen juist heel divers. Als zo’n cultuur een minderheid vormt in de dataset van namen, dan zal ons spambotdetectie-algoritme hen onevenredig vaak als spambots beschouwen. Kortom, statistische patronen die voor een meerderheid gelden, kunnen compleet verschillend zijn voor een minderheidsgroep.

Toolkit voor eerlijker algoritmes

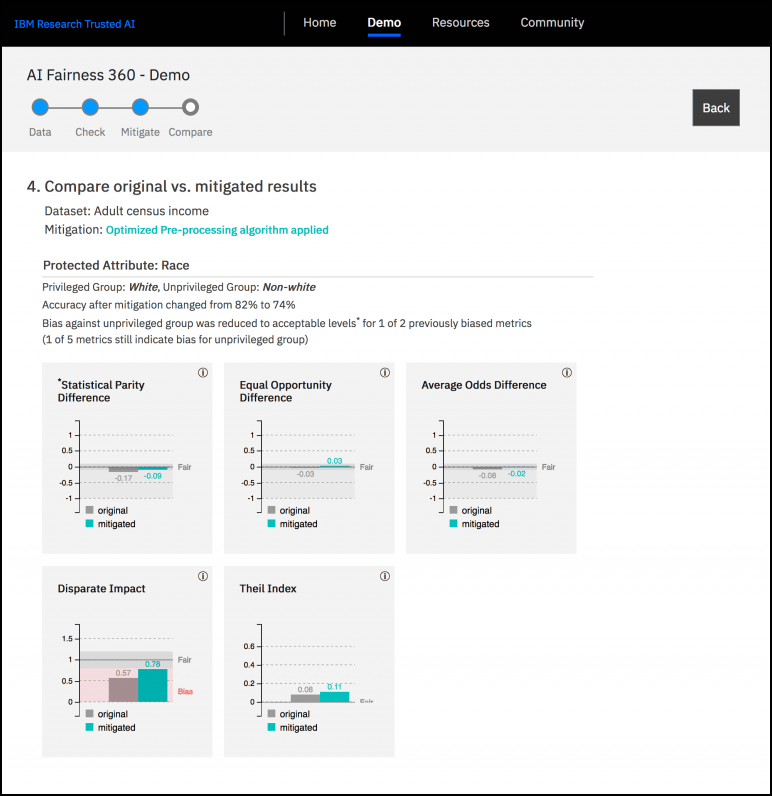

IBM werkt aan een oplossing en heeft met AI Fairness 360 (http://aif360.mybluemix.net/) een opensource toolkit uitgebracht waarmee je vooroordelen in modellen voor machinaal leren kunt herkennen en beperken. De software gebruikt maar liefst 70 ‘eerlijkheidsstatistieken’ en heeft 10 mogelijke algoritmes om machinaal leren eerlijker te maken. Je kunt de software zelf in je eigen Python-programma’s integreren. Het project bevat ook enkele demo’s (http://aif360.mybluemix.net/data) waarmee je zelf voorbeelddatasets kunt verkennen en zien hoe machinaal leren daar vooroordelen in herkent. Je kunt er ook interactief zelf kiezen met welke algoritmes je de vooroordelen aanpakt.

De opensource toolkit AI Fairness 360 van IBM helpt ontwikkelaars

om hun AI-code eerlijker te maken

Mens of machine

Je kunt ook argumenteren dat we misschien te streng zijn voor computers. Ja, algoritmes voor machinaal leren hebben vooroordelen, maar mensen hebben dat ook, en binnen zekere grenzen die de ergste uitwassen elimineren accepteren we dat. Dus is het niet voldoende als we gewoon de ergste vooroordelen in algoritmes vermijden, die bijvoorbeeld tot seksisme en racisme leiden? Maar dan vergeten we het al vermelde versterkende effect. Eén computer verwerkt data op veel grotere schaal dan één mens en kan met vooroordelen dus veel meer schade aanrichten.

Bovendien is er ook het psychologische effect van computers. Mensen geloven vaak blindelings wat een computer zegt, omdat ze denken dat het objectief is, puur wiskunde toegepast, zonder emoties. Maar emotieloze wiskunde betekent niet per definitie objectief als je data vooroordelen bevat. In computerwetenschappen wordt wel eens de uitdrukking ‘garbage in, garbage out’ gebruikt: een computersysteem kan nog zo intelligent zijn, als je het verkeerde data voedt, krijg je verkeerde resultaten. Voor veel mensen is het echter vaak ‘garbage in, gospel out’: als de computer iets zegt, moet het wel waar zijn, onafhankelijk van de kwaliteit van de data. In combinatie met oneerlijke algoritmes kan deze houding heel veel schade aanrichten.

Mensen geloven vaak blindelings wat een computer zegt omdat ze denken dat het objectief is

Voorspellend politiewerk

Daarom hebben organisaties zoals de digitale burgerrechtenbeweging Electronic Frontier Foundation in 2016 al een oproep gedaan om voorzichtig te zijn met technologie zoals ‘predictive policing’ (https://bit.ly/2Utw7Jd). Bij deze toepassing van machinaal leren, probeert een algoritme te voorspellen wanneer iemand criminele feiten gaat plegen. Je krijgt dus ergens in een database een stempel ‘potentiële crimineel’, terwijl je nog niets fout hebt gedaan.

In de VS is software voor predictive policing big business. Die gebruikt informatie zoals de locatie en tijdstippen van gerapporteerde misdrijven en oproepen naar het 911-nummer, maar volgens critici verzamel je zo vooral informatie over het antwoord van de politie op misdrijven, niet over de misdrijven zelf. Door op deze gekleurde informatie verder te werken, versterkt het algoritme nog de vooroordelen van de politie.

In hun oproep om voorzichtig om te gaan met deze technologie, merkten de kritische organisaties overigens fijntjes op dat nog maar weinig politiedepartementen waarin technologie voor predictive policing gangbaar is, deze ook inzetten om wangedrag van hun eigen politieagenten te voorspellen, en dat terwijl wangedrag vaak na consistente gedragspatronen volgt die zeker zo gemakkelijk te analyseren zijn als het gedrag van potentiële criminelen. Waarom gebeurt dat niet?

Geef de mens de keuze

Een deel van de oplossing is waarschijnlijk om algoritmes niet meer volledig autonoom één uitkomst te laten berekenen waar wij als mens dan absoluut zeker over zijn, maar om opties te geven met bijbehorende informatie om de mens te helpen bij zijn keuze. Stel dat een AI-systeem een arts helpt bij medische beslissingen. In plaats van één behandeling te voorspellen, kan het drie mogelijke behandelingen suggereren: één die de levensduur van de patiënt het meest verlengt, één die het lijden van de patiënt minimaliseert en één die de kostprijs zo laag mogelijk houdt. Het AI-systeem zegt dan eigenlijk: “Ik weet niet wat de beste oplossing is, maar dit zijn de opties en hun gevolgen.” De eindverantwoordelijkheid ligt dan nog altijd bij de arts.

Algoritmes die hun beslissingen uitleggen

Een mogelijke oplossing om de ‘oneerlijkheid’ van algoritmes aan te pakken, is algoritmes ontwikkelen die de redenering achter hun beslissingen kunnen uitleggen. Dan kunnen mensen die redenering nog altijd bekijken en ingrijpen als ze zien dat door die redenering een specifieke minderheidsgroep gediscrimineerd wordt. Maar bijna alle goed werkende algoritmes voor machinaal leren van vandaag maken gebruik van neurale netwerken en in het bijzonder deep learning. En laat die algoritmes nu net ongelooflijk ondoorzichtig zijn. Het is alsof je een black box hebt waar je data instopt en beslissingen uit krijgt, maar je hebt geen flauw idee wat er in die doos gebeurt. Accountable machine learning is een boeiend onderzoeksdomein, maar de eerste bruikbare toepassingen zijn nog verre toekomstmuziek.