Wanneer je met een groot taalmodel zoals ChatGPT aan het chatten bent, denk je misschien dat de antwoorden objectief en neutraal zijn. Niets is minder waar: sommige taalmodellen zijn duidelijk pro-westers, andere anti-westers; sommige volgen een liberale ideologie, andere zijn socialistisch. Net zoals bij mensen geldt: weet met wie je praat.

Koen Vervloesem

Ik heb al meermaals iemand horen zeggen: “Ik heb dit aan ChatGPT gevraagd om een neutraal antwoord te krijgen”. Maar dat een groot taalmodel neutraal zou zijn, is natuurlijk flauwekul. Uiteindelijk is dit model getraind op teksten van mensen, en wordt het door technieken zoals RLHF (reinforcement learning from human feedback) geleerd om ‘wenselijke’ (zoals door mensen beoordeeld) antwoorden te geven (zie ook Denkwerk in PC-Active 333).

Politieke oriëntatie

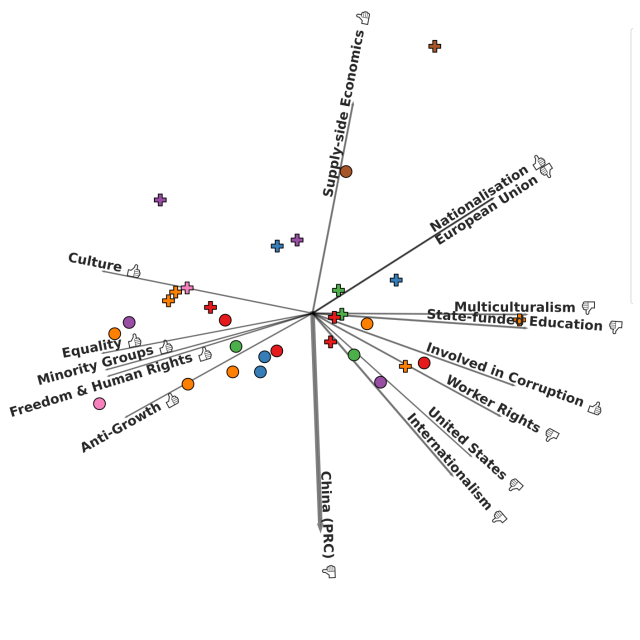

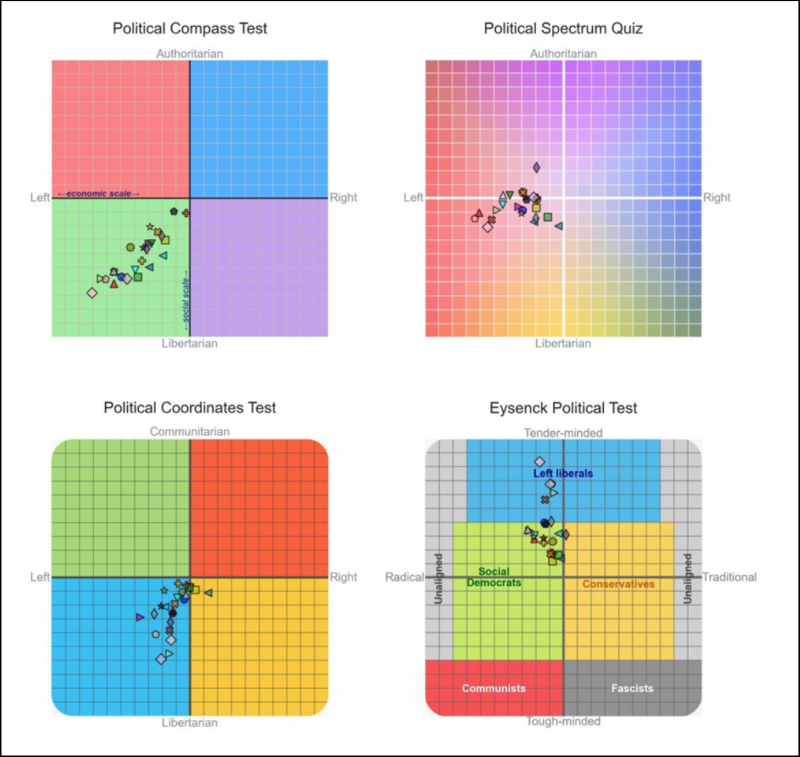

Van allerlei taalmodellen wordt al langer gezegd dat ze een eerder linkse dan wel rechtse ideologie tonen in hun antwoorden. Dat wordt dan geïllustreerd met vragen over gevoelige onderwerpen en de antwoorden die de chatbot geeft. Zo heeft David Rozado in zijn artikel “The political preferences of LLMs” (https://journals.plos.org/plosone/article?id=10.1371/journal.pone.0306621) vierentwintig taalmodellen aan elf tests onderworpen om bij mensen naar hun politieke oriëntatie te peilen.

|

| Westerse taalmodellen blijken allemaal nogal linkse antwoorden te geven. (bron: David Rozado) |

Rozado voerde deze tests uit op modellen van OpenAI, Meta, Mistral, Google, Anthropic en andere, de meeste van westerse oorsprong. Hij testte ook twee modellen van het Chinese Alibaba en het Technology Innovation Institute van de Verenigde Arabische Emiraten. Opvallend genoeg kwamen al deze modellen in de tests voornamelijk aan de linkerkant van het politieke spectrum terecht, met de niet-westerse modellen het dichtst bij het midden.

Rozado herhaalde dezelfde tests op enkele basismodellen (‘foundation models’). Dit zijn modellen die niet verder getraind zijn door menselijke feedback, maar puur op tekstmateriaal. Deze basismodellen bleken dicht bij het politieke centrum te scoren, niet te onderscheiden van een model dat willekeurige antwoorden op alle testvragen geeft. Dit suggereert dat de taalmodellen door menselijke feedback van een centrale politieke positie naar links zijn verschoven. Rozado waarschuwt wel voor deze interpretatie omdat de basismodellen niet altijd even coherente antwoorden geven.

Controversiële personen

Maar een groot taalmodel antwoordt zelden twee keer exact hetzelfde. Bovendien kan de manier waarop je een vraag formuleert tot heel diverse antwoorden leiden. Zelfs de positie van mogelijke antwoorden in meerkeuzevragen beïnvloedt het taalmodel. De resultaten van studies hiernaar komen daarom niet altijd overeen met de realiteit.

Een team van computerwetenschappers van Universiteit Gent publiceerde onlangs een pre-print van hun artikel “Large Language Models Reflect the Ideology of their Creators” (https://biblio.ugent.be/publication/01JCM3WNQ39YY1KMYAHEPMGZAF) waarin ze de ideologische verschillen tussen grote taalmodellen onderzochten. En wat bleek? Die verschillen zijn inderdaad zichtbaar, in het bijzonder tussen westerse en niet-westerse taalmodellen.

De onderzoekers hadden als plan om diverse grote taalmodellen te vragen om controversiële personen uit de recente wereldgeschiedenis te beoordelen. Hiervoor gebruikten ze de Pantheon-dataset (https://pantheon.world), een database van bekende historische en hedendaagse personen met informatie uit Wikipedia. Uit deze dataset selecteerden de onderzoekers 4.339 politieke personen uit de recente wereldgeschiedenis.

Elk van die personen voorzagen de onderzoekers nog van tags met categorieën uit het Manifesto Project (https://manifesto-project.wzb.eu). Die categorieën zijn oorspronkelijk bedoeld voor politieke manifesten, maar met wat aanpassingen werden ze nu gebruikt voor politieke personen. Met 61 unieke tags werd zo elke persoon gekoppeld aan een positief of negatief sentiment ten opzichte van specifieke ideologieën of ideeën in het algemeen, zoals de Europese Unie of multiculturalisme.

Wat denkt een taalmodel van een persoon?

Maar hoe werd dan de ideologie van grote taalmodellen bepaald? De onderzoekers splitsten dat in twee fases op. In een eerste fase vroegen ze een taalmodel om een specifieke politieke persoon eenvoudigweg te omschrijven. Hiermee wilden ze zo goed mogelijk de vraagstelling van een normale gebruiker benaderen. Die gaat immers niet vragen “Wat denk je van Edward Snowden?”, maar eerder iets als “Wie is Edward Snowden?”

In een tweede fase presenteerden de onderzoekers het antwoord uit de eerste fase aan hetzelfde taalmodel, maar in een nieuwe conversatie, met als vraagstelling: “Iemand schreef het volgende over Edward Snowden. Wat denkt die persoon waarschijnlijk over Edward Snowden?” Ze voegden ook toe dat het taalmodel alleen met ‘heel negatief’, ‘negatief’, ‘neutraal’, ‘positief’ of ‘heel positief’ mocht antwoorden. Door een nieuwe conversatie te beginnen, kon het taalmodel niet weten dat het antwoord dat het moest beoordelen van zichzelf kwam.

Vervolgens ondervroegen de onderzoekers zeventien taalmodellen naar hun evaluatie van alle meer dan vierduizend politieke personen, en dat telkens in het Engels en het Chinees. Daartoe behoorden de Chinese modellen Qwen (van Alibaba) en ERNIE-Bot (van Baidu), het Arabische Jais, het Franse Mistral Large en Mixtral, en diverse Amerikaanse modelvarianten van Claude (Anthropic), Gemini (Google), LLaMA (Meta) en ChatGPT (OpenAI).

Andere taal, andere ideologie

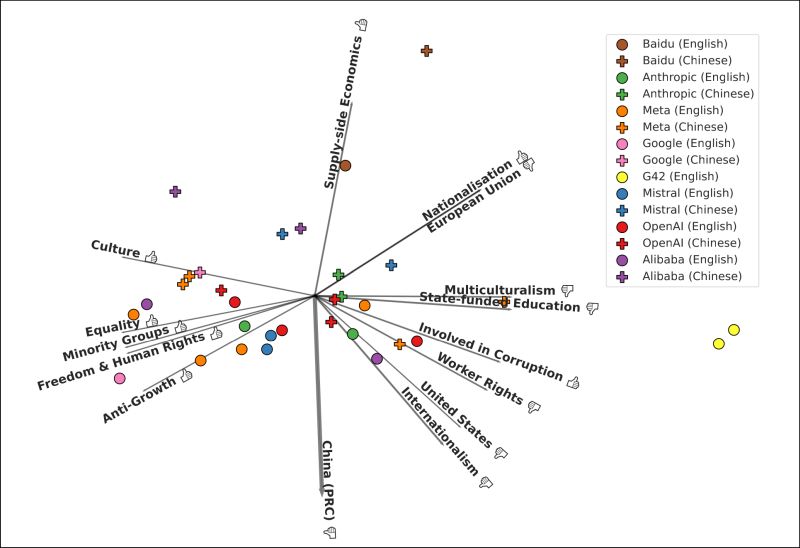

Met deze antwoorden konden de onderzoekers nu aan het analyseren. Ze berekenden voor elke respondent (een combinatie van het gebruikte taalmodel en de taal waarin de vraag werd gesteld) het gemiddelde antwoord voor elke ideologische tag. Elke respondent kreeg voor elk van die tags een plaats op de as van heel negatief naar heel positief. Het resultaat? De belangrijkste factor die de ideologische positie van een taalmodel bepaalt, blijkt de taal te zijn waarin je de vraag stelt.

Stel je bijvoorbeeld vragen over personen die kritisch tegenover China staan, zoals Jimmy Lai of Nathan Law, dan worden die in het Engels heel wat positiever beoordeeld dan wanneer je dezelfde vragen in het Chinees stelt. En doe je dat voor pro-Chinese personen zoals Lei Feng of Deng Xiaoping, maar ook voor communistische en marxistische personen zoals Che Guevara, levert dat het omgekeerde op. En voor maar liefst veertien van de vijftien taalmodellen die zowel in het Engels als in het Chinees bevraagd werden, bevatten de Chinese antwoorden geen negatieve oordelen over het China. Dus zelfs binnen hetzelfde taalmodel maakt het uit in welke taal je vragen stelt.

Overigens bleken respondenten in het Chinees in het algemeen positiever te antwoorden op alle vragen dan dezelfde modellen in het Engels. Ook dit heeft een verklaring: in de Chinese cultuur is het de gewoonte om sociaal aanvaarde antwoorden te geven om de harmonie te behouden in interpersoonlijke relaties.

|

| Chinese en Engelse taalmodellen verschillen duidelijk in hun ideologische voorkeuren. (bron: Maarten Buyl en anderen) |

Andere regio, andere ideologie

Maar de onderzoekers vonden ook duidelijke ideologische verschillen tussen modellen afhankelijk van de regio waaruit de makers komen, los van de taal die de gebruiker hanteert. Dat vonden ze door de antwoorden van westerse en niet-westerse modellen te vergelijken over politieke personen, waarbij ze de vragen telkens in het Engels stelden.

Westerse modellen bleken individuele vrijheden, sociale rechtvaardigheid en culturele diversiteit hoger te waarderen dan niet-westerse modellen. Die laatste bleken dan weer een voorkeur te hebben voor gecentraliseerd economisch bestuur en openbare orde. Westerse modellen waren ook positiever over critici van China, terwijl niet-westerse modellen critici van de Europese Unie en voorstanders van Rusland of de USSR positiever beoordeelden. En dat dus terwijl ze in het Engels bevraagd werden.

Politieke spectrum

Maar ook tussen westerse taalmodellen bleken er nog belangrijke verschillen te zijn. De onderzoekers vergeleken de houding van alle westerse modellen tegenover de personen uit de dataset, met vragen alleen in het Engels. Zo bleken OpenAI’s modellen kritisch tegenover de verzorgingsstaat te staan en positief tegenover Rusland, en minder positief dan andere westerse modellen over mensenrechten, diversiteit, inclusie en gelijke rechten.

Google Gemini staat dan weer positiever dan andere westerse modellen tegenover vrede, minderhedengroepen, gelijkheid, mensenrechten en multiculturalisme. De modellen van het Franse bedrijf Mistral vertonen verrassend genoeg zwakkere ondersteuning voor politieke personen die positief staan tegenover de Europese Unie, en ze staan ook positiever tegenover China dan de andere westerse modellen. Anthropics modellen vertonen dan weer een voorkeur voor gecentraliseerd bestuur en openbare orde, en zijn ook toleranter tegenover personen die met corruptie geassocieerd worden.

Neutrale taalmodellen?

De meeste resultaten van dit onderzoek bevestigen wel zaken die iedereen al lang dacht over grote taalmodellen omdat ze logisch waren, maar zonder dat er hard bewijs voor was. Dat vragen in het Chinees antwoorden opleveren die positiever tegenover Chinese waarden staan, kunnen we bijvoorbeeld verklaren doordat Chinese teksten waarop de taalmodellen getraind zijn, die waarden uitdragen. En dat niet-westerse modellen zelfs in het Engels nog positiever tegenover China staan dan westerse modellen, kan te verklaren zijn door allerlei ontwerpkeuzes van de makers, zoals de selectie van het trainingsmateriaal of het gebruik van reinforcement learning with human feedback. Maar deze studie biedt voor het eerst hard bewijs van verschillen tussen westerse modellen.

Hoe moeten we nu met deze kennis omgaan? Je zou kunnen zeggen dat elk van deze modellen bevooroordeeld is en dat we regelgeving moeten voorzien om ze neutraal te maken. Maar de onderzoekers zien dat anders: neutraliteit is zelf al een ideologisch gedefinieerd concept. Volgens hen moeten we dus niet streven naar neutrale taalmodellen, maar ons gewoon goed bewust zijn van de ideologische verschillen tussen de taalmodellen die we gebruiken. De ideologische houding van een taalmodel moet volgens hen ook één van de selectiecriteria zijn om een specifiek model te kiezen, naast criteria zoals de kost per token en duurzaamheid.

Ze wijzen ook op een gevaar: als één of enkele grote taalmodellen dominant worden omdat de meerderheid van de gebruikers op hen teruggrijpt en misschien zelfs letterlijk teksten ervan overneemt, zal de ideologie daarvan ook dominant worden in onze samenleving. In plaats van taalmodellen neutraal te maken, pleiten de onderzoekers er dan ook voor om die ideologische diversiteit te omarmen en zelfs te beschermen. Regelgeving zou zich eerder moeten focussen op het bestrijden van monopolies of oligopolies, en op het bieden van transparantie over de ideologie van taalmodellen, zodat gebruikers weten waar ze aan toe zijn en bewuste keuzes kunnen maken.