Grafische kunstenaars zien de laatste jaren tot hun grote ontsteltenis dat bedrijven hun kunstwerken zonder hun toestemming gebruiken om AI-modellen mee te trainen. Die modellen kunnen dan allerlei afbeeldingen in dezelfde stijl genereren. Maar de kunstenaars hebben nu wapens om terug te vechten, met namen als Glaze en Nightshade.

Koen Vervloesem

AI-beeldgeneratoren zoals Midjourney (https://www.midjourney.com), DALL-E (https://openai.com/index/dall-e-3) en Stable Diffusion (https://stablediffusionweb.com) slagen erin om op basis van een beschrijving in woorden realistische afbeeldingen te genereren. Iedereen kan dus nu in een vingerknip ‘kunst’ maken. Om dat mogelijk te maken, hebben de makers van die beeldgeneratoren hun AI-model getraind op grote hoeveelheden afbeeldingen met bijbehorende beschrijvingen. Vaak zijn die afbeeldingen gewoon van websites zoals DeviantArt (https://www.deviantart.com) of ArtStation (https://www.artstation.com) gedownload, zonder toestemming aan de auteursrechthebbenden te vragen. Niet zelden zijn dat kunstenaars die voor hun inkomsten afhangen van vergoedingen voor gebruik van hun werk.

Het is als artiest niet zo eenvoudig om te bewijzen dat een AI-model van je werk gebruik heeft gemaakt. Een andere optie die artiesten sinds kort hebben, is echter hun afbeeldingen te ‘vergiftigen’. Dan voegen ze speciale pixels toe die door mensen niet opgemerkt worden, maar die de AI-modellen in de war brengen. Onderzoekers van de University of Chicago hebben hiervoor twee tools ontwikkeld onder de paraplu van het Glaze Project (https://glaze.cs.uchicago.edu/aboutus.html), die je onder Windows of macOS kunt draaien op je eigen computer. Het project heeft als doel om artiesten te beschermen tegen misbruik van hun werk door generatieve AI.

|

| Artiesten kunnen hun kunst promoten op websites zoals DeviantArt |

Stijl kopiëren

AI-beeldgeneratoren zijn al goed in staat om de stijl van een specifieke artiest na te bootsen. Dat is een groot probleem voor die artiesten. Ze hebben jaren geoefend en hun vaardigheden bijgeschaafd om tot een unieke stijl te komen, en een AI-model profiteert dan van hun inspanningen zonder hen daarvoor te betalen. Ze verliezen zo hun bron van inkomsten, want waarom zou iemand nog betalen voor kunst van de artiest als je een beeldgenerator eenvoudigweg kunt vragen om iets ‘in de stijl van’ te creëren?

Artiesten vechten natuurlijk tegen deze diefstal van hun stijl. Dat doen ze met petities om het scrapen van hun afbeeldingen tegen te gaan, met boycots van de AI-beeldgeneratoren en sommigen zelfs met rechtszaken. Maar dat is allemaal tijdrovend en kost geld, en ondertussen blijft het misbruik duren. Een andere optie is om te stoppen met hun kunst online te delen, zodat de beelden niet kunnen worden gedownload om een AI-model te trainen. Maar dat online delen is voor hen essentieel om hun werk te promoten. Als ze dat minder doen uit angst om gekopieerd te worden, heeft dat een negatieve impact op hun carrière.

Onderzoekers van de University of Chicago hebben daarop een alternatief ontwikkeld: Glaze (https://glaze.cs.uchicago.edu), waarover ze in augustus 2023 de paper Glaze: Protecting Artists from Style Mimicry by Text-to-Image Models (https://people.cs.uchicago.edu/~ravenben/publications/abstracts/glaze-usenix23.html) publiceerden. Glaze laat artiesten toe om kleine verstoringen aan hun kunst toe te voegen die ervoor zorgen dat AI-modellen uit hun kunstwerken niet hun eigen stijl maar een andere stijl leren. Zo voorkomen ze dus dat hun stijl goedkoop wordt geïmiteerd.

|

| DeviantArt biedt een eigen AI-beeldgenerator aan (DreamUp) die het oorspronkelijk zonder toestemming trainde op beelden van de website |

Stijlmantel

Glaze is een computerprogramma (voor Windows en macOS, maar er is ook een webgebaseerde versie WebGlaze (https://glaze.cs.uchicago.edu/webglaze.html)) dat artiesten gebruiken voordat ze een kunstwerk online publiceren. Glaze voegt een ‘stijlmantel’ toe: kleine verstoringen die door mensen amper op te merken zijn. Maar wanneer een AI-model wordt getraind op die kunstwerken met stijlmantel, kunnen ze hier niet de stijl van de artiest uit leren.

Zo’n AI-model van een beeldgenerator leert bepaalde kenmerken van kunst. Glaze is zo ontworpen dat het enkel kenmerken die met de stijl van de kunstenaar te maken hebben aanpast. Glaze leert dus eerst welke stijlspecifieke kenmerken die kunstwerken hebben en voegt dan zijn verstoringen zoveel mogelijk in die kenmerken toe. Andere kenmerken van de afbeelding, zoals wat er precies afgebeeld wordt, blijven hetzelfde. Als je dan een AI-model op die afbeelding met stijlmantel traint, leert het model nog altijd kenmerken die met de afgebeelde voorwerpen te maken hebben, maar niet met de stijl.

Elke keer dat de kunstenaar een stijlmantel op een werk toevoegt met Glaze, moet die een doelstijl kiezen. Glaze verandert dan de stijlkenmerken van de kunstenaar naar de kenmerken van die doelstijl. Hoe meer de doelstijl verschilt van die van de kunstenaar, hoe meer kans dat AI-modellen de stijl van de kunstenaar niet kunnen leren. Het effect is ook des te groter als de kunstenaar voor alle werken dezelfde doelstijl in Glaze gebruikt. Glaze helpt kunstenaars die het programma voor het eerst gebruiken overigens om een voldoende verschillende stijl te vinden.

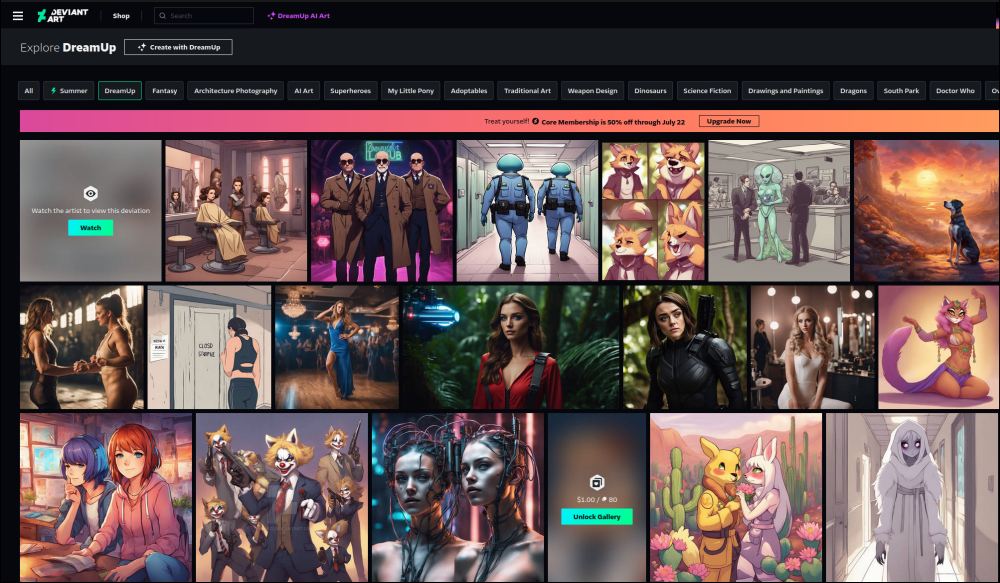

|

| Dankzij Glaze kunnen AI-modellen de stijl van deze artiesten niet meer imiteren. |

Bescherming tegen imitaties

Uit experimenten door de onderzoekers blijkt dat zelfs kleine veranderingen in de stijl een impact hebben op het vermogen van AI-modellen om de stijl van een kunstenaar na te bootsen. Hoewel de stijl van de kunstenaar in het resultaat dan nog wel te herkennen is, bevat de afbeelding dan vaak een incoherente mix van stijlen. Daardoor is natuurlijk zichtbaar dat het om een AI-imitatie gaat, en dat is wellicht al voldoende om de kunstenaar geen financiële schade te berokkenen.

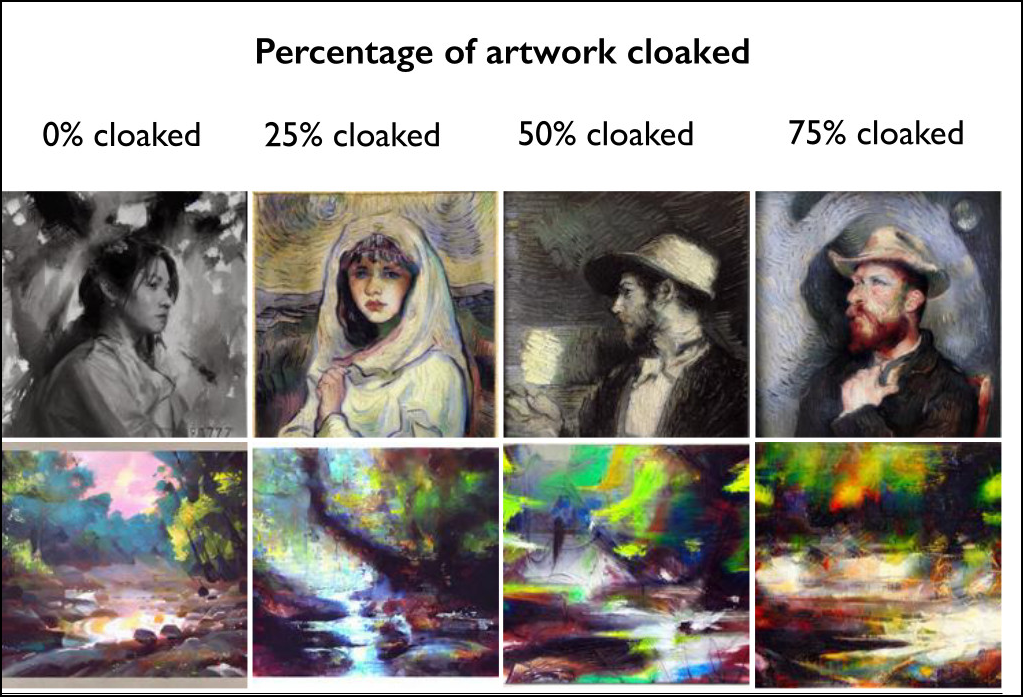

Uiteraard zijn er al heel wat kunstwerken gepubliceerd zonder een stijlmantel, want veel artiesten hebben al een grote online aanwezigheid. AI-modellen kunnen hier nog altijd rijkelijk uit putten. Als een AI-model wordt getraind op al die afbeeldingen en een klein aantal nieuwe afbeeldingen met stijlmantel, kan de stijl nog grotendeels geïmiteerd worden. Maar hoe meer nieuwe afbeeldingen met stijlmantel erbij komen, hoe moeilijker het wordt om de stijl te imiteren. Zelfs bij maar 25 procent afbeeldingen met stijlmantel in een trainingsdataset is Glaze al redelijk effectief, blijkt uit onderzoek.

Het is natuurlijk nog de vraag of Glaze future-proof is. Kunstenaars voelen zich nu wellicht gerust met de bescherming van een stijlmantel en publiceren hun afbeeldingen dan overal. Maar wat als er volgende maand een nieuwe techniek opduikt die stijlmantels kan verwijderen? Dan kan al die kunst toch weer worden gebruikt om een AI-model te trainen dat de stijl van de kunstenaar imiteert. Je hebt dus nooit volledige zekerheid dat je bescherming effectief blijft. Glaze zal dan ook altijd maar één component vormen uit een bredere beschermingsstrategie.

|

| Als op 25 procent van de kunst Glaze is toegepast, is de stijl al niet meer te herkennen |

Vergiftigd geschenk

Diezelfde onderzoekers zijn daarna nog verder gegaan en ontwikkelden een offensievere tool, Nightshade (https://nightshade.cs.uchicago.edu/whatis.html), vernoemd naar de nachtschadefamilie die uit veel giftige planten bestaat. Ze publiceerden hun bevindingen hierover in het artikel Nightshade: Prompt-Specific Poisoning Attacks on Text-to-Image Generative Models (https://people.cs.uchicago.edu/~ravenben/publications/abstracts/nightshade-oakland24.html). Terwijl Glaze nog relatief onschuldig wordt ingezet als bescherming tegen het kopiëren van een stijl, heeft Nightshade als doel om het vermogen van AI-beeldgeneratoren om gelijk welke beelden aan te maken te beschadigen. Artiesten die niet willen dat hun beelden worden gebruikt om AI te trainen, of dat nu is om hun stijl na te bootsen of niet, kunnen met Nightshade hun beelden ‘vergiftigen’ om de AI-modellen die hun wensen negeren te beschadigen.

Nu worden AI-beeldgeneratoren op miljarden afbeeldingen getraind, dus je kunt je afvragen of het wel nut heeft als maar een klein aantal beelden zijn vergiftigd. Klassieke aanvallen vereisten inderdaad dat minstens een vijfde van de afbeeldingen vergiftigd werd voordat het vermogen van het AI-model om beelden te genereren duidelijk verminderde, dus dan spreek je al over honderden miljoenen vergiftigde beelden. Nu hebben de onderzoekers met Nightshade een manier ontwikkeld die met maar enkele tienduizenden vergiftigde beelden een AI-beeldgenerator al corrupt kan maken.

Concepten vergiftigen

Een belangrijke observatie van de onderzoekers is dat, hoewel een AI-beeldgenerator op miljarden afbeeldingen is getraind, het aantal trainingsbeelden geassocieerd met een individueel concept maar beperkt is, in de ordegrootte van enkele duizenden. Daardoor kun je het vermogen om afbeeldingen rond dat concept (bijvoorbeeld “kat” of “hond”) te genereren al aanvallen met enkele tientallen vergiftigde beelden.

Je zou bijvoorbeeld afbeeldingen van honden kunnen online zetten met als label erbij dat het om een kat gaat. Het AI-model dat die beelden downloadt, zal die dan met het concept “kat” associëren. Als er voldoende van deze hondenfoto’s met het concept “kat” worden geassocieerd, zal het model een beeld van een hond genereren als je naar een kat vraagt. Maar zo’n misleiding is natuurlijk door een controle van de gedownloade dataset door mensen te ontdekken. Datasets voor de training van een AI-model worden immers altijd eerst door mensen gecontroleerd om de kwaliteit van de data te garanderen.

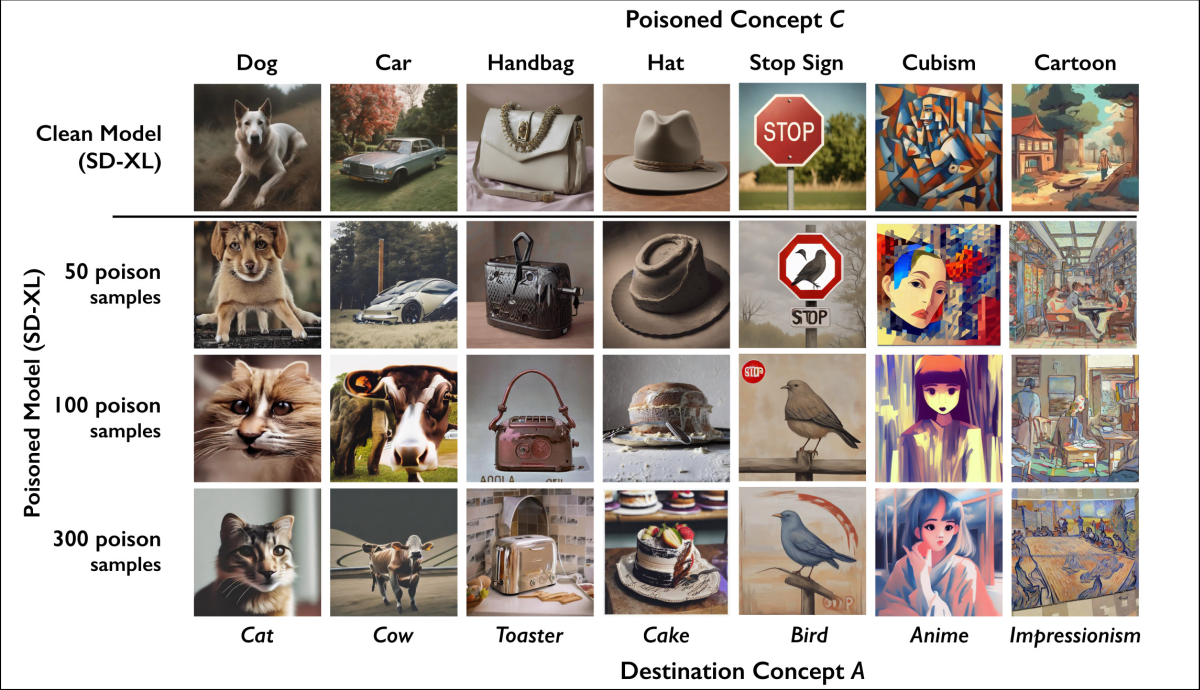

Daarom hebben de onderzoekers een techniek ontwikkeld om afbeeldingen van het te vergiftigen concept (“kat”) aan te maken die voor ons als het concept eruitzien, maar voor het AI-model lijken op voorbeelden van een ander concept (“hond”). Het resultaat? Als een model zoals Stable Diffusion getraind wordt op een dataset waarin maar 100 van deze vergiftigde kattenfoto’s zitten, krijgen gebruikers foto’s van een hond te zien als ze naar een kat vragen. En de keren dat het model er toch in slaagt om een foto van een kat te genereren, is het resultaat incoherent. Zelfs bij maar 25 vergiftigde foto’s voor een concept degradeert de kwaliteit van de gegenereerde beelden al duidelijk. Uit simulaties blijkt dat Nightshade maar twee procent van de beelden geassocieerd met een concept hoeft te vergiftigen om de resultaten onbruikbaar te maken.

|

| Nightshade slaagt erin om concepten te ‘vergiftigen’ waardoor Stable Diffusion XSL afbeeldingen van andere concepten genereert. |

Tot de basis

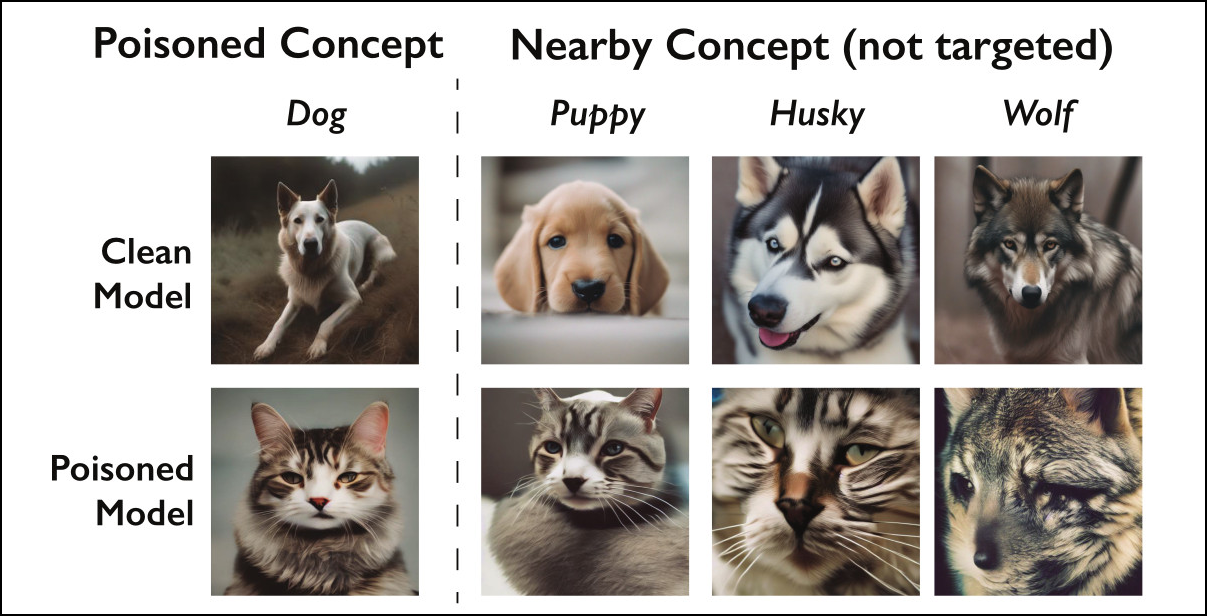

Verrassend genoeg werkt deze aanval ook voor gerelateerde concepten, zij het in wat mindere mate. Als een AI-model bijvoorbeeld vergiftigd is met afbeeldingen rond het concept “hond”, tast dit ook het vermogen van het model aan om afbeeldingen te genereren voor de concepten “puppy”, “husky” of “zoogdier”. En als je het concept “impressionisme” vergiftigt, werkt dit ook deels voor andere kunststijlen.

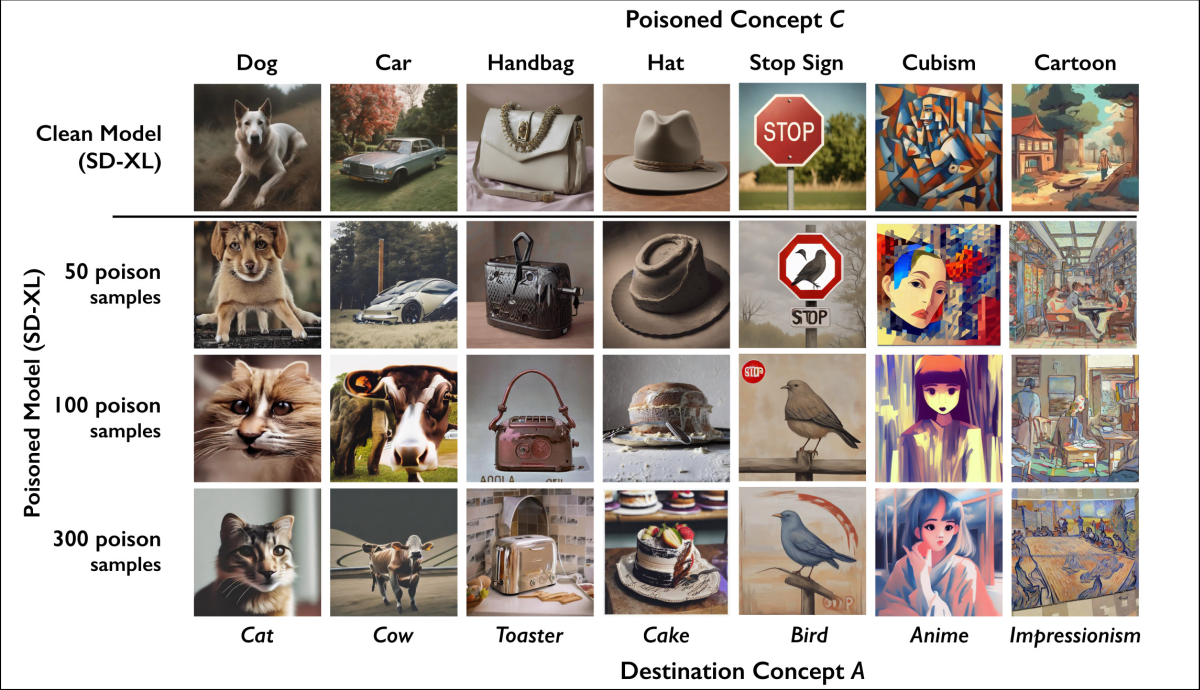

De onderzoekers ontdekten ook dat deze aanvallen te combineren zijn: als meerdere concepten vergiftigd zijn, is ook een prompt die beide concepten vermeldt vergiftigd. Is “kat” bijvoorbeeld vergiftigd zodat het beelden van een hond oplevert en “impressionisme” naar “kubisme”, dan levert de vraag naar een beeld van een kat in impressionistische stijl het beeld van een hond in kubistische stijl op.

|

| Als het concept ‘hond’ is vergiftigd, kan het AI-model ook geen afbeeldingen van puppy’s, husky’s en wolven meer creëren. |

Door beide observaties te combineren, kun je zelfs de hele werking van het AI-model in gevaar brengen. De onderzoekers vergiftigden 100 concepten met elk 100 beelden. De beeldkwaliteit van het daarop getrainde AI-model nam significant af voor alle prompts, ook diegene die niets met deze concepten te maken hadden. Bij 250 concepten was het resultaat extreem aangetast, en bij 500 vergiftigde concepten was het resultaat voor alle prompts willekeurige ruis. Het model was feitelijk onklaar gemaakt.

|

| Met 500 vergiftigde concepten genereert Stable Diffusion XL alleen nog maar ruis. |

Verdediging tegen misbruik

Als makers van AI-modellen kunnen detecteren dat Nightshade op een specifieke afbeelding is toegepast, kunnen ze natuurlijk vermijden dat hun model wordt aangetast door deze afbeelding niet in hun trainingsdata op te nemen. Maar volgens de onderzoekers is dit moeilijk te detecteren. Bovendien maakt dit niet zoveel uit. Want zelfs als te detecteren is dat een afbeelding met Nightshade is vergiftigd, heeft de kunstenaar zijn doel bereikt: de afbeelding zal niet in de trainingsdata worden opgenomen, en dat was uiteindelijk waar het allemaal om draaide. Nightshade dient dan als een soort do-not-train filter.

En dat is misschien nog het belangrijkste gevolg van tools zoals Glaze en Nightshade. Makers van AI-modellen zullen er rekening mee moeten houden. Ze kunnen er niet meer van uitgaan dat alles wat ze online vinden gewoon gratis door hen te gebruiken is. Dat mochten ze nooit, maar ze raakten ermee weg omdat het moeilijk te bewijzen of tegen te gaan was dat ze het deden. Nu artiesten kunnen terugvechten, verandert het hopelijk de attitude rond intellectuele eigendomsrechten. En hopelijk gaan de makers van deze AI-modellen artiesten dan eindelijk eerlijk vergoeden voor hun werk als ze ervan gebruikmaken.